top of page

All Posts

AI 시대의 새로운 인프라 경제학!'추론 워크로드' 중심의 차세대 데이터센터 전략

생성형 AI의 등장은 단순한 기술적 발전을 넘어 산업 경제의 구조를 근본적으로 바꾸는 거대한 흐름이 되었습니다. 초기에는 거대 언어 모델(LLM)의 훈련에 관심이 쏠렸지만, 이제는 AI의 진정한 가치가 드러나는 추론 워크로드로 시선이 옮겨가고 있습니다. AI의 가치와 장기적인 전략 목표가 학습한 모델로 사용자의 요구에 응답하는 추론으로 바뀐 것입니다. 자연스럽게 AI 데이터센터 구축과 운영 관련 CAPEX, OPEX를 따질 때에도 추론 워크로드 처리를 매우 중요하게 바라보게 되었습니다. 왜 '추론'이 핵심이 되었나? 몇 년 전만해도 막대한 자원을 투입하는 '훈련'이 모두의 관심사였습니다. 그러나 AI 모델 생태계의 발전과 다양한 유즈 케이스가 등장하면서 기업들은 AI 투자의 무게중심이 훈련에서 추론으로 빠르게 옮겨가게 되었습니다. AI의 가치는 모델을 소유하는 것에서 나오는 것이 아닙니다. 모델을 '사용'하는 과정에서 창출됩니다. 이런 인식이 확산

KAYTUS, MotusAI로 '추론 시대'의 과제를 해결하다!

AI 산업의 무게 중심이 모델 '훈련(Training)'에서 대규모 '추론(Inference)'으로 빠르게 옮겨가고 있습니다. 이제 기업은 훈련한 모델을 실제 프로덕션 환경에 배포해 가치를 만드는 '추론' 단계에 집중합니다. 추론은 AI 챗봇의 답변, 금융 사기 탐지, 의료 영상 분석처럼 AI 기술이 비즈니스 최전선에서 실질적인 역할을 하는 핵심 엔진입니다. AI 인프라 솔루션 선도 기업인 KAYTUS는 '추론 시대'의 복잡한 요구에 대응하기 위해 하드웨어부터 소프트웨어까지 아우르는 통합 전략을 제시합니다. 특히 독일 함부르크 'ISC High Performance 2025'에서 공개한 최신 MotusAI AI DevOps 플랫폼은 단순한 업데이트를 넘어, 대규모 AI 추론 환경의 근본적인 문제를 해결하는 포괄적인 해답을 제시합니다. KAYTUS의 전략과 그 핵심인 MotusAI 플랫폼의 가치를 분석하고, 이번 최신 업데이트가 AI...

지능형 관제의 진화,Vision AI의 한계를 넘어 VLM이 여는 새로운 미래

공공, 민간 부문 어디이건 관제 센터는 끊임없이 늘어나는 CCTV가 쏟아내는 영상 데이터의 홍수 속에서 운영됩니다. 소수의 관제 요원이 수십, 수백 개의 화면을 동시에 살피는 현실은 인간의 물리적, 인지적 한계를 시험합니다. 이런 상황에서 등장한 AI는 수동적인 '기록'과 '감시'에 머물던 관제 패러다임을 능동적인 '탐지'와 '대응'으로 전환을 이끈 기술 혁신이었습니다. AI는 지치지 않는 눈으로 방대한 영상을 분석하며 관제 효율을 극대화했습니다. 하지만 이는 시작에 불과했습니다. 1세대 지능형 관제를 이끈 Vision AI가 효율성 증대의 발판을 마련했다면, 진정한 혁명은 이제 막 시작되고 있습니다. 시각과 언어를 동시에 이해하는 비전 언어 모델(Vision Language Model, 이하 VLM)은 인간과 관제 시스템의 관계를 근본적으로 재정의하고 있습니다. AI, 관제 센터의 '눈'이 되다 CCTV 기반 지능형 관제는 AI가 보안 카메라 영

AI 기반 운전자 모터링 시스템, 왜 NPU가 최선의 선택일까요?

운전자 모니터링 시스템(Driver Monitoring System, 이하 DMS)은 이제 차량 옵션 사양을 넘어 미래 자동차의 핵심이자 법적으로 의무화된 안전 기술로 자리 잡아 가고 있습니다. DMS의 기본 개념부터 NPU를 활용한 장치 구현 방안을 알아보겠습니다. DMS 개념과 핵심 기술 DMS는 차량 내부에 장착한 근적외선(NIR) 카메라 같은 센서와 AI 알고리즘으로 운전자의 상태를 실시간으로 파악하는 능동형 안전 시스템입니다. 이 시스템의 가장 중요한 목표는 졸음운전이나 부주의로 발생하는 교통사고를 예방하는 것입니다. DMS는 보통 네 가지 단계를 거쳐 작동합니다. 먼저 NIR 카메라로 운전자의 얼굴 이미지를 감지하고 AI 모델이 이 이미지에서 얼굴 특징점, 머리 위치, 시선 방향, 눈 깜빡임 빈도 등 핵심 생체 정보를 분석합니다. 시스템은 이 정보를 종합해 운전자가 졸고 있는지 혹은 주의가 산만한지 판단하고, 위험 상황이라고 판단되면 즉

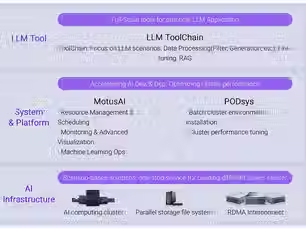

최고의 성능과 효율을 보장하는 KAYTUS의 풀스택 AI

GPU 클러스터 구축은 험난한 여정입니다. 경험 없이 시작하면 시행착오를 피할 수 없습니다. 알아야 할 것이 너무 많아서 인데요. 고가의 GPU 자원이 제 성능을 내지 못하거나 자원 활용률이 목표치보다 낮게 나오면 튜닝의 늪에 빠질 수 있습니다. 서버, 스토리지, 네트워크를 잘 아는 인프라 전문가와 플랫폼 엔지니어링 전문가를 최적화 작업에 투입할 수 있다면 내재화 측면에서 도전해 볼만한 작업입니다. 하지만 역량을 갖춘 팀을 보유하고 있지 않은 것이 현실이죠. 이런 시장의 고민을 해결하기 위해 인프라 전문 기업들은 각자의 장점을 살린 풀스택 AI를 제안합니다. 이번 포스팅에서는 대원씨티에스 파트너인 KAYTUS의 풀스택 AI 전략을 살펴보겠습니다. KAYTUS의 선택과 집중 전략 KAYTUS는 AI 인프라, 시스템/플랫폼, LLM 도구로 풀스택 AI를 구성합니다. 한 눈에 봐도 사전에 최적화를 한 조합임을 알 수 있습니다. 사실 GPU 기반 AI 클

클라우드를 닯아 가는 AI 데이터센터 전략, LLM 추론 워크로드 최적화를 위해 새로운 선택지 ‘LPU’

요즘 AI 인프라 트렌드를 보면 클라우드를 많이 닮아가고 있는 것을 알 수 있습니다. 특히 AI 워크로드 최적화 컨셉을 아키텍처 설계 단계부터 고려하는 것이 눈에 띄게 닮았습니다. 대원씨티에스는 이런 흐름을 일찍부터 감지하고 GPGPU 서버 외에도 NPU, LPU 기반 인프라를 아키텍처 설계 전략에 반영하기 위해 국내 주요 AI 가속기 기업과 파트너십을 맺어오고 있습니다. AI가 모델 훈련의 시대를 넘어 이제 실질적인 비즈니스 가치를 창출하는 추론 시대로 접어 드는 것에 맞춰 대원씨티에스는 워크로드 유형에 맞는 운영, 비용, 확장 등을 고려해 훈련, 미세 조정, 추론을 위한 최적의 AI 가속기 활용 방안을 제시합니다. 이번 포스팅에서는 추론 워크로드를 위한 선택지 중 하나인 LPU(LLM Processing Unit)에 대해 알아볼까 합니다. LPU와 GPGPU, NPU의 차이 LPU는 NPU(Neural Processing Unit)의 하위 범주

AI 데이터센터에 맞는 AIOps 기반 운영 & 관리가 필요

AI 데이터센터는 구축과 운영 모두 비용이 많이 들지만 조직의 미래 비전과 전략 실행의 근간이다 보니 투자 우선 순위가 높습니다. 이처럼 중요한 시설 투자일 수록 24시간 365일 장애나 중단 없이 GPU 자원을 효율적으로 활용하며 안정적으로 돌아가야 합니다. 이번 포스팅에서는 KAYTUS의 KSManage 도구로 AIOps 기반 AI 데이터센터 인프라 운영과 관리 방식을 어떻게 바꿀 수 있는지 살펴보겠습니다. 한계에 도달한 전통적 운영 방식 전통적인 데이터센터 운영 방식은 여러모로 AI 데이터센터와 맞지 않습니다. 그 이유는 크게 이기종 환경, 매뉴얼 방식의 관리, 사후 대응에 초점을 맞춘 모니터링에서 찾아 볼 수 있습니다. 일반적인 데이터센터는 여러 벤더의 장비가 혼재된 이기종 장비로 구성되어 있습니다. 각 장비가 고유의 관리 인터페이스와 프로토콜을 사용하다 보니 자연스럽게 운영 환경이 파편화되고 사일로화됩니다. 이런 조건에서는 자원 활용 현황

AI 시대의 역설, 왜 비싼 GPU는 잠자고 있을까?

최신 GPU 확보를 위한 경쟁 열기가 여전합니다. AI 데이터센터를 조직의 중요 투자 대상으로 삼는 곳이 늘면서 한정된 GPU 자원 확보 경쟁이 갈수록 치열해지고 있습니다. 그렇다면 GPU 자원은 확보만 하면 되는 것일까요? 막대한 투자 이면에는 낮은 GPU 활용률이라는 불편한 진실이 숨어 있습니다. 활용률이 낮은 이유 낮은 GPU 활용률 문제의 근본 원인을 파악하려면 GPU를 넘어 시스템 전체를 바라보아야 합니다. GPU 활용률은 단일 지표가 아니라 컴퓨팅, 메모리, 데이터 입출력(I/O)이 복잡하게 얽힌 결과물입니다. 낮은 GPU 활용률을 초래하는 핵심적인 기술적 병목 현상은 여러 가지가 있습니다. 데이터 병목 현상(Data Starvation)부터 알아보겠습니다. 강력한 GPU도 처리할 데이터가 제때 공급되지 않으면 멈춰 섭니다. 느린 스토리지 I/O, 네트워크 지연, 비효율적인 데이터 전처리 파이프라인으로 인해 GPU가 데이터를 기다리며 유

추론 서비스를 위한 AI 데이터센터 구축 가이드

현재 많은 기업이 AI 모델을 프로덕션 환경에 배포해 추론 서비스를 제공하는 과정에서 기술적 장벽에 부딪히고 있습니다. 비효율적인 GPU 자원 활용, 느린 배포 속도, 낮은 안정성, 그리고 감당하기 어려운 운영 비용은 AI 전환을 가로막는 주요 요인입니다. 이는 최신 GPU를 장착한 서버를 도입한다고 해결할 수 있는 문제가 아닙니다. 성공적으로 프로덕션 추론 인프라를 구축하려면 컴퓨팅, 네트워킹, 냉각, 그리고 지능형 소프트웨어를 긴밀하게 통합하는 풀스택(Full-Stack) 접근법이 필수입니다. 이번 포스트에서는 대원씨티에스의 파트너인 KAYTUS가 제안하는 효율적인 AI 추론 환경 구축을 위한 가이드를 정리해 보았습니다. AI 추론 최적화를 위한 고려 사항 AI 추론은 단일한 워크로드가 아닙니다. 거대 언어 모델(LLM)이나 멀티 모달 언어 모델(MMLM) 기반 추론 서비스는 Prefill과 Decode 두 단계로 분리해 최적화하는 전략이 중요

Arista의 이더넷 중심의 AI 데이터센터 시장 전략 & 대원씨티에스의 역할

AI 데이터센터의 중요성은 강조할 필요가 없습니다. 기업은 AI 데이터센터를 차세대 혁신의 모태로 여기고 있습니다. 정부는 AI 데이터센터를 국가의 미래 경쟁력을 좌우하는 핵심 인프라로 바라봅니다. 이런 분위기 속에서 GPU 못지 않게 뜨거운 관심을 모으는 분야가 있습니다. 바로 네트워킹입니다. GPU 자원 활용률을 극대화하는 동시에 AI 데이터센터 TCO에 큰 영향을 끼치는 것이 바로 네트워크 인프라이다 보니 자연스럽게 GPU와 함께 조명을 받는 것입니다. 독점과 개방의 대결 2025년 현재 AI 데이터센터 네트워크 인프라 시장은 두 개의 컨셉이 맞붙고 있는 형국입니다. 하나는 모두가 잘 아는 NVIDIA가 주도하는 수직 통합 방식의 독점 기술 스택입니다. NVIDIA는 DPU, 인피니밴드, 스펙트럼-X 같이 자사 주도의 기술 스택을 제안하고 있습니다. 다른 하나는 이더넷을 중심으로 한 개방형 생태계입니다. 하이퍼스케일러부터 오랜 기간 네트워크

동영상 시장의 구조적 변화와 차세대 인코딩 기술로 ASIC이 주목받는 이유

2025년 현재 우리는 OTT와 유튜브가 공중파 방송보다 더 큰 영향력을 끼치고 있고 전국에 촘촘히 설치한 공공 부문의 CCTV가 촬영한 동영상이 치안, 안전, 행정, 교통 등 중요 대민 서비스를 지탱하는 시대를 살고 있습니다. 이처럼 다양한 목적으로 디지털 플랫폼 상에서 처리하는 동영상이 민간과 공공 영역에서 폭발적으로 증가하며 관련 기술 시장은 구조적 변화를 맞이하고 있습니다. 이 변화의 핵심은 동영상 인코딩에 특화한 ASIC입니다. 패션 유행이 돌고 돌듯이 동영상 인코딩 분야도 ASIC에서 소프트웨어 정의 방식으로 그리고 다시 ASIC으로 유행이 바뀌었습니다. 차세대 인코딩 기술로 다시 ASIC에 관심이 몰리는 이유를 살펴보겠습니다. 동영상 인코딩 기술의 진화 동영상 인코딩 기술은 시대의 기술적 한계와 새로운 비즈니스 요구에 발맞춰 끊임없이 진화의 길을 걷고 있습니다. 지금까지의 변천사를 되짚어보면 앞으로 어떤 기술이 대세가 될 것인지 가늠해

AI 데이터센터, 훈련에서 추론으로의 패러다임 전환

ChatGPT의 전 세계 사용자 수가 2025년 말 10억 명을 바라보는 시대입니다. 생성형 AI가 촉발한 AI가 창출하는 새로운 비즈니스 가치에 대한 공감이 확산하면서 자연스럽게 엔터프라이즈의 관심사는 훈련(Training)에서 추론(Inference)으로 전환되고 있습니다. 이러한 패러다임의 전환은 AI 데이터센터 전략에도 영향을 끼치고 있습니다. 대표적인 것이 플랫폼 운영 전략입니다. 거대한 GPU 자원 풀의 활용률을 극대화하는 데 있어 훈련과 추론 워크로드를 모두 고려해야 하기 때문입니다. AI 모델 훈련 워크로드는 수 페타바이트(PB)의 데이터를 처리하기 위해 수백, 수천 개의 GPU를 몇 주 또는 몇 달간 독점적으로 사용합니다. 이 워크로드의 유일한 목표는 최대한 빠르게 모델을 훈련하는 데 필요한 처리량(Throughput) 확보입니다. 반면에 AI 모델을 기반으로 실제 서비스를 제공하는 프로덕션 환경의 AI 추론 워크로드는 지향점이 다

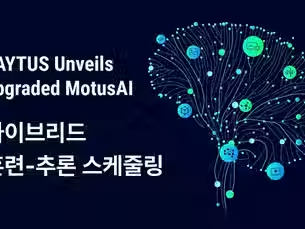

MotusAI를 통합 AI DevOps 플랫폼이라 부르는 이유는?

AI 패러다임이 추론 중심으로 전환됨에 따라 GPU 자원 활용률 최적화는 더 이상 기술적 과제가 아닌 기업의 생존과 경쟁력을 좌우하는 핵심 전략 과제가 되었습니다. MotusAI는 단일 노드 하이브리드 스케줄링과 유연한 GPU 가상화 툴킷을 통해 R&D의 속도와 프로덕션 서비스의 안정성을 단일 통합 인프라 위에서 동시에 달성할 수 있다는 가능성을 제시하고 있습니다. 이를 기능 측면에서 살펴보겠습니다. 스케줄링 유휴 용량 문제를 해결하는 MotusAI의 핵심 전략은 훈련과 추론 워크로드를 동일한 하드웨어에서 동적으로 통합 조율하는 데 있습니다. 이는 훈련과 추론 클러스터를 물리적으로 분리하던 전통적인 방식과의 근본적인 차별점입니다. MotusAI는 단일 노드에서의 하이브리드 훈련-추론 스케줄링 기능을 제공합니다. 이를 통해 단일 노드 또는 클러스터에서 두 가지 유형의 워크로드를 동적으로 혼합 배치(Mixed Orchestration)할 수 있습니다.

더 깊게 생각하는 AI, 폭증하는 비용, Agentic AI 시대의 성공적인 AI 인프라 전략

파운데이션 모델 기반 생성형 AI가 대중의 관심을 끌기 시작하던 2022년 말만 해도 AI 업계와 기술 커뮤니티의 화두는 GPU와 훈련이었습니다. 하지만 2025년 현재는 민간, 공공 영역에서 AI 서비스가 프로덕션 환경에 배포되면서 관심사는 추론과 NPU 같은 전용 가속기로 옮겨갔습니다. 그리고 자연스럽게 어떻게 하면 추론 성능을 최적화하고 TCO를 낮출 것인지에 대한 이야기가 오가고 있습니다. 그렇다면 모델은? 대규모로 GPU를 확보해 운영할 수 있는 예산과 인력이 있는 대기업이나 빅테크가 아닌 이상 파운데이션 모델을 직접 훈련하지 않습니다. 일반 기업이나 테크 기업 그리고 공공 기관의 경우 허깅페이스 같은 모델 리포지토리에서 필요한 파운데이션 모델이나 도메인 특화 모델을 가져와 미세 조정해 씁니다. 더불어 사내 보유 데이터와 도메인 지식을 RAG로 보완하는 것이 표준처럼 자리를 잡았습니다. 달라진 인프라 요구 사항 AI가 프로덕션 환경에 본격

KAYTUS MotusAI가 일본 유수 대학의 연구 인프라를 혁신하는 방식

대학의 연구 인프라로 오랜 기간 슈퍼컴과 HPC(High Performance Computing) 클러스터가 중요한 역할을 담당했습니다. 이 자리에 최근 엄청난 존재감을 보이며 등장한 컴퓨팅 환경이 있습니다. 바로 GPU 서버로 구성한 AI 클러스터입니다. 민간 분야 못지 않게 대학도 이제 AI 없는 연구 혁신은 생각할 수 없습니다. 이처럼 중요성이 커지고 있는 AI 클러스터는 투자 못지 않게 관리 부담도 큽니다. 관련해 이번 포스팅에서는 KAYTUS의 MotusAI로 기업 못지 않은 AI 클러스터 운영 역량을 확보한 일본의 대학 사례를 살펴보겠습니다. AI로 업의 본질을 찾아가는 대학의 양방향 전략 일본의 한 유수 연구 대학이 KAYTUS의 MotusAI를 도입한 이유는 AI를 단순한 도구로 소비하는 것을 넘어, 대학의 핵심 역량으로 내재화하려는 전략적 비전이 있었기 때문입니다. 이 대학은 AI 기술 발전을 선도함과 동시에 이를 생물학, 물리

대원씨티에스, AI 인프라 솔루션으로 비즈니스 영토 확장

AI인프라 전략실 신설하고 하이퍼스케일 AI 구축 사업 등 신규 사업 개척 2024년 2월 8일 – 지난 35년간 IT 유통에 전념해온 대원씨티에스(대표 김보경, 이상호, 하성원)가 AI 인프라 솔루션으로 비즈니스 영역을 확장한다. 대원씨티에스는 오래 전부터 사업다각화를 꾸준히 추진해왔다. 그동안 PC, 서버, 워크스테이션, 네트워크, 스토리지 등 기업 IT 인프라 구축을 위한 하드웨어와 솔루션 등을 공급해온 대원씨티에스는 데이터센터 솔루션 및 AI 서비스, 고성능 컴퓨팅 등으로 사업 영역을 확장해 나가고 있다. 사회 전반에 생성형 AI가 확산되면서 IT 인프라 구축에 대한 고객의 환경과 니즈도 급변하고 있다는 판단 때문이다. 이에 따라 대원씨티에스는 지난 2022년 IT유통에 이어 급성장하는 데이터센터 솔루션·서비스 부문으로 사업영역을 확대하기 위해 인공지능(AI), 고성능컴퓨팅(HPC), 클라우드, 네트워크 전문가들로 구성된 데이터센터사

대원씨티에스-딥엑스, AI 솔루션 확산 위해 ‘맞손’

국내 AI 인프라 비즈니스 주도 대원씨티에스와 AI 반도체 개발기업 딥엑스 총판 계약 체결 (2024. 4. 12) 국내 최대의 IT 인프라 공급업체인 대원씨티에스(대표 하성원, 이상호, 김보경)는 11일, 국내 최대의 AI 반도체 스타트업인 딥엑스(대표 김녹원)와 총판 계약을 체결했다. 대원씨티에스는 11일, 판교 딥엑스 본사에서 김녹원 대표이사, 정명천 대원씨티에스 회장 등 양사 관계자들이 참석한 가운데 온디바이스 AI 솔루션을 전산업으로 확산하기 위해 B2B, B2C 비즈니스 총판 계약을 체결했다고 밝혔다. 대원씨티에스는 1988년 창립된 회사로 국내에서 AMD, 델, 슈퍼마이크로, 케이투스 등 글로벌 반도체 및 서버 업체들의 국내 총판을 담당하고 있다. 또한 LG, 삼성, HP 등 국내외 IT 제조사와 총판 계약을 통해 국내 IT 제품의 유통을 주도해왔으며, 작년 7,200억의 유통 매출을 달성했다. 생성형 AI 기술의 확산과 더불어

대원씨티에스, 바스트 데이터와 총판 계약 체결

한국 내 AI 시장 발전 속도에 부응하기 위한 행보…대원씨티에스, AI 엔터프라이즈 기업으로 포지셔닝 (2024년 5월 16일) 국내 최대의 IT 인프라 공급업체인 대원씨티에스(대표 하성원, 이상호, 김보경)가 AI 데이터 플랫폼 기업인 바스트 데이터(VAST Data)와 총판 계약을 체결했다고 16일 밝혔다. 글로벌 엔터프라이즈 AI 소프트웨어 기업인 바스트 데이터는 국내 AI 시장 공략에 박차를 가하고 있다. 대원씨티에스와 바스트 데이터는 이번 총판 계약을 통해 세계에서 가장 빠르게 성장하고 있는 한국 AI 시장 진출을 가속화할 수 있는 발판을 마련했다. 바스트 데이터 플랫폼은 대원씨티에스가 제공하는 AI 인프라에서 가장 핵심 요소이다. 바스트 데이터 플랫폼은 생성형 AI와 거대언어모델(LLM)을 뛰어넘어 데이터 수집, 정제, 학습 및 추론에 이르는 ‘AI 기반 발견(AI-Assisted Discovery)’을 단일 플랫폼에서 구현하며 가속

대원씨티에스, AI 비즈니스 첫 발…바스트 데이터 파트너 설명회 성료

국내 중견 SI 기업 30여개사 참가해 뜨거운 AI 시장 분위기 반영 (2024년 6월 27일) 최근 바스트 데이터(VAST Data)와 총판 파트너십을 체결한 국내 최대의 IT 인프라 공급업체인 대원씨티에스(대표 하성원, 이상호, 김보경)가 파트너 설명회를 개최하고 AI 비즈니스의 첫 발을 뗐다. 판교에 위치한 ABN타워에서 개최한 바스트 데이터 파트너 행사에는 중견 SI 및 엔비디아 파트너사 등 30여개사가 참가해 뜨거운 관심을 반영했다. 대원씨티에스 AI 사업부문 김광정 대표의 환영사를 시작으로, 바스트 데이터 파트너들에 대한 기술지원 및 기술교육 정책 등이 소개되었고, 다양한 판매 프로모션 등이 발표됐다. 유클릭, 굿모닝아이텍, 아이크래프트 등 참석한 파트너들은 바스트 데이터의 제품으로 국내 시장을 어떻게 개척해 나갈지 열띤 질의응답을 벌였다. 지난 5월 총판 계약을 체결한 대원씨티에스는 이번에 모집한 파트너들과 함께 바스트 데이터의 A

대원씨티에스, 차세대 AI 구축 전략 컨퍼런스 첫 개최

선도적 AI 기업들과 함께 ‘DIA 넥서스 서밋 2024’ 통해 이정표 제시 (2024. 8. 22) 국내 최대의 IT 인프라 공급업체인 대원씨티에스(대표 김보경, 이상호, 하성원)가 AI 시장에 포문을 연 이후 처음으로 국내 최대 규모의 AI 컨퍼런스를 개최한다. 대원씨티에스는 오는 9월 3일 페어몬트 앰배서더 서울 호텔 그랜드볼룸에서 DIA 넥서스 서밋(DIA Nexus Summit) 2024 컨퍼런스를 개최한다고 밝혔다. ‘AI 중심의 치세대 연결성 전략’이라는 부제로 개최되는 이번 컨퍼런스의 DIA는 대원씨티에스의 새로운 AI 비즈니스 브랜드인 ‘DAEWON CTS Innovative AI’의 약자로 다이아몬드의 이미지처럼 지능적인 발전과 혁신을 상징하며 넥서스는 기술과 아이디어의 결정적 연결점을 의미한다. 이 의미처럼 이번 컨퍼런스에서는 선도적인 AI 기업들이 함께 참여해 AI 기술의 발전과 응용 가능성을 심층적으로 논의하는 자리가 될

bottom of page

.png)